6月15日,据科技博客Techcrunch报道,Facebook人工智能研究所(Facebook Artificial Intelligence Research,简称FAIR)的研究人员已经创建了人工智能模型,它们被赋予了与人类谈判的能力,可以与人讨价还价。

我妈听说了这个消息感到很心痛,认为连“讨价还价”都可以让人工智能来的话,极大地剥夺了她去菜场买菜的乐趣。

FAIR的报告中,还提到,他们有一次不得不更换了模型,原因是“代理人已发展了自己的协商语言”。

(图片来源于网络)

不少媒体以“人工智能发展出了自己的语言”这样的标题报道了这一研究中的插曲。

那么,人工智能真的发展出了自己的语言吗?发展出自己的语言是不是很快就可以说点人类都听不懂的悄悄话,开始造反啦?

人工智能领域专家,科大讯飞研究院北京分院副院长付瑞吉,为我们解答了这些疑惑。

问:

付老师您好,不管是Siri,还是微软小冰,不少朋友已经习惯人工智能可以聊天,还可以假装手机里有个男/女朋友。那么这次人工智能会“谈判”为何能获得这么高的关注度?“谈判”和“聊天”有何不同?

答:

最大的不同在于,**谈判需要和“对手”博弈,从而达到“自己”利益的最大化,**此前的聊天功能并无这个特点,机器人可以顺着用户的话说,或者和用户一起协作完成某项任务(比如:订机票、查询信息等)。

问:

那么是否可以理解成,聊天是无关决策的消遣,而谈判是要对情境进行分析、判断并做决定?

答:

闲聊是漫无目的的,开发AI和人闲聊,其目标是希望AI尽可能具备“像人一样”思维和语言能力,微软小冰是一个典型的例子;实际上,聊天并不都是漫无目的的闲聊,很大一部分聊天是为了完成特定的任务的,比如苹果的Siri可以帮用户完成手机操作、信息查询等指令,像一个小秘书,当然Siri也有部分闲聊的功能,但并非其主要功能。国内科大讯飞的灵犀也有类似的功能,可以完成天气、餐馆、酒店、景点等信息搜索,以及车票/机票预订、口语翻译等任务。那么,**谈判实际上也是一种特殊的任务,**目的是谈判成功并使自己的利益最大化。只不过,**谈判任务需要和“对手”博弈,**这点和以往的任务不同。

至于是否需要对情境进行分析、判断,并根据分析判断结果决定“说”什么,不管是闲聊还是面向特定任务的聊天,都是需要的。

问:

从研发的难度来说,谈判是不是更难一些?

答:

只要问题定义好,任务目标能够很好地用数学函数表示出来,那么机器就可以学习起来。因此在我看来,这个谈判任务并不比在此之前的其他“聊天”任务更难。

问:

谈判功能的产生,对人工智能的发展意味着什么?

答:

**谈判这个任务的设定比较巧妙,以往的研究大多是针对“人机”对话,而谈判这个任务可以让两个AI进行“机机”对话,**是比较让人眼前一亮的。但就它能对人工智能领域的影响,我觉得并没有外界想象的那么大,而是否能由此为起点引发一些变革,也不得而知。

问:

目前有新闻指出,Facebook的研究人员表示,有一次他们不得不更换了其中一个模型,因为如果不这样做,机器人之间的对话“就会和人类语言产生差异,因为代理人已发展了自己的协商语言”。

这是否意味着人工智能的发展有可能失控?这个事件有什么意义?是否是人工智能产生“自我”的开始?

答:

语言是一种通讯的符号,如果不以人类的自然语言来约束机器人,那么他们之间通过相互训练可能发生漂移,而产生人类看不懂的“符号”,姑且可以叫做满足特定任务的“语言”。

**但这并不能说明人工智能产生了“自我”,只说明机器人用一种特殊的符号串进行信息传递而已。**事实上,Facebook的谈判机器人的“欲望”都是数据集中人工设定好的。

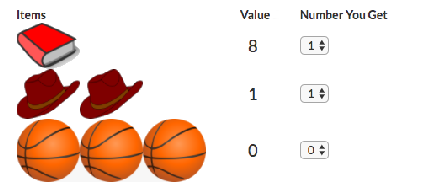

比如:书、帽子、球对于不同机器人的有不同的价值。并不是机器人有了“自我”意识而产生的。

至于说谈判过程中产生的“撒谎”行为,那只是对于人类行为的模仿,都是从训练数据中学到的。

问:

能否整体评价一下这一进展?

答:

Facebook的这个工作很有趣,将谈判任务转换为可计算的目标,然后两个Agent“谈判切磋”,利用强化学习(reinforcement learning)算法来学习谈判的过程,类似于Alphago的自我对弈。就这个任务本身来说,还是非常限定性的。我们可以考虑将现实中的问题想办法转换为这种形式,采用类似的形式进行求解。

看来,目前还不用担心人工智能造反的问题。反倒是这项有趣的研究,为我们利用人工智能来解决现实问题,提供了参考。

扫码下载APP

扫码下载APP

科普中国APP

科普中国APP

科普中国

科普中国

科普中国

科普中国