万引大神: 机器学习不存在了

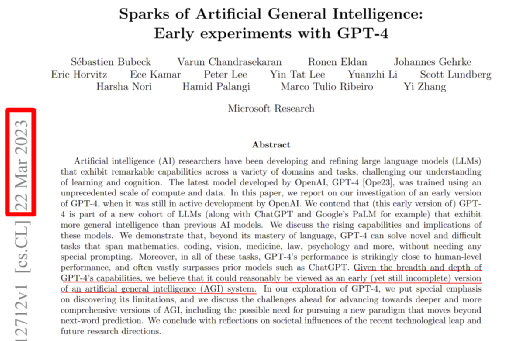

微软总部研究院机器学习理论组负责人万引大神Sébastien Bubeck联手2023新视野数学奖得主Ronen Eldan、2023新晋斯隆研究奖得主李远志、2020斯隆研究奖得主Yin Tat Lee等人,在其论文《通用人工智能的火花:GPT-4早期实验》中申明:“GPT-4可被视作AGI (人工通用智能)的早期版本”。这项研究最近30天关注度极高,众多大佬争相转发。

大神们做了非常专业的评测,虽然最后结论措辞偏向保守,但也实实在在认定了GPT4在AGI方向质的飞跃,同时也印证了笔者的刚刚接触ChatGPT时候的判断:ChatGPT是第一个真正意义的人工通用智能 。

GPT-4展示了在推理、问题解决和语言能力方面的巨大提升。标志着人工智能的一个“相变”,并加速进步。为此微软研究院制作了一系列播客,AI科学家兼工程师Ashley Llorens与他的同事对话,探讨现在及未来的这类新模型,对人们创造、理解和部署人工智能,在医疗保健和教育等领域的应用,以及最终其造福人类意味着什么。第一集节目就邀请了Sebastien Bubeck,探讨这篇论文中的发现,内容详见文末“原文链接”-- AI前沿:Sébastien Bubeck解析AI物理学。

其中笔者对下面这段高度关注,Bubeck宣称传统机器学习已经不存在了,他和他的团队全面转向 AI 物理学。与笔者近期的几篇文章的观点不谋而合。研究大模型的机理,微软研究院有得天独厚的资源优势,应该也可以看到GPT的模型内部,期待他们落地的有价值的发现,而不是像笔者能做的仅仅是理论上的推演。

ChatGPT是第一个真正意义的人工通用智能

OpenAI首席科学家透露GPT4技术原理

GPT4技术原理一:学习语言需要相变

GPT4技术原理二:相变与涌现

Ashley Llorens: 我想回到你早些时候提到的自然进化与人工进化的概念。我认为这开始暗示了你想要将这个领域带到哪里的方向,至少在你的研究和团队方面。那就是,关注涌现的方面以及智能如何涌现。那么,从这一点出发,从你刚才描述的与 Lego 的合作中,你和这个领域的未来会朝着什么方向发展呢?

Sebastien Bubeck:是的,绝对。因此,我认为或许我们需要为机器学习取一个新的名字。GPT-4和GPT-3以及其他所有大型语言模型,在某种程度上,已经不再是机器学习了。我的意思是,机器学习的全部意义在于如何教机器完成一个非常明确定义的任务?比如识别猫和狗。但在这里,这并不是我们所做的。我们不是在试图教它一个狭窄的任务。我们试图教它所有事情。我们也不是在模仿人类学习的方式。这是另一个困惑的地方。有些人说,哦,但它正在学习语言,但是使用比任何人类都要多的标签。

但这有点错了。问题在于我们不是在模仿人类的学习。这就是为什么学习也许不再是正确的词语了。我们真正试图模仿的是一些类似于进化的东西。我们试图模仿数以亿计的实体与世界互动的经验。在这种情况下,世界就是人类生产的数据。

因此,这是一种非常不同的风格。我认为我们在机器学习中引入的所有工具在GPT-4的光芒下几乎无用且不相关,因为这是一个新领域。这是需要新工具来定义的东西。因此,我们希望处于这一领域的前沿,我们想引入这些新工具。

当然,我们不知道它会是什么样子,但我们尝试研究的方法是尝试理解“涌现现象”。因此,“涌现现象”是指当您扩大网络和数据时,每个规模都会出现新属性的现象。Google进行了一个实验,将其大型语言模型从80亿扩展到600亿到5000亿。

在80亿时,它能够理解语言。在600亿时,突然间它能够翻译不同的语言。之前它无法翻译。在5000亿时,它突然能够解释笑话。为什么它突然能够解释笑话?

因此,我们真的希望理解这一点。还有另一个领域长期以来一直在研究“涌现现象”,即我们试图研究非常复杂的粒子相互作用的系统,以及导致某些涌现行为的系统。

这是什么领域?这是物理学。因此,我们想要提出的建议是,让我们研究人工智能的物理学或者通用人工智能的物理学,因为从某种意义上讲,我们现在真正看到的是这种通用智能。那么,研究通用人工智能的物理学意味着什么?它的意思是,让我们试着借鉴物理学家过去几个世纪用来理解现实的方法论。

那么,这些工具是什么呢?其中之一是运行非常受控的实验。如果你看看瀑布,观察流动的水,水朝着各种方向流动,然后在冬天去看,水都结冰了。光凭看瀑布,GPT-4或LAMDA或者Flash语言模型是很难理解水相的。这些都是瀑布。我们需要更小尺度的非常受控的实验,确保我们有纯净的水,它没有被石头或者藻类污染。我们需要这些受控的实验来理解它。乐高积木就是一个例子。这是我们想要走的一个方向。但在物理学中,还有另一个方向,就是建立真实世界的玩具数学模型。

你试着将许多东西抽象出来,最终留下一个非常简单的数学方程,你可以对其进行研究。然后你必须回到实验中去,看看玩具数学模型的预测是否告诉你一些关于真实实验的东西。所以这是我们想要走的另一个途径。最近我们还与微软研究院的实习生取得了一些进展。

我们有一篇论文,名为“学习阈值单元”。在这里,我们真正能够理解最基本的元素,我不想说智能,但是在这些神经网络中推理最基本的元素是如何出现的。这个最基本的推理元素是什么?它是一个阈值单元。它是一个接受某些值作为输入的东西。如果这个值太小,它就把它变成零。这种出现已经是一个非常复杂的现象了。我们能够理解这种非凸动力学,以及与之相关的稳定边缘,这都是非常令人兴奋的。但关键是,我们有一个玩具数学模型,在本质上我们能够说出现与训练不稳定性有关,这非常令人惊讶,因为通常在传统的机器学习中,不稳定性是你不想要的东西,你想要消除所有的不稳定性。通过这种AI物理学方法,我们有一个玩具数学模型,我们能够说实际上训练中的不稳定性,每个人在几十年来都看到的,实际上对学习和出现很重要。所以这是我们采取的第一步。

作者:王庆法 麻省理工学院物理系学者,数据领域专家,首席数据官联盟专家组成员

扫码下载APP

扫码下载APP

科普中国APP

科普中国APP

科普中国

科普中国

科普中国

科普中国