投稿作者:许涵文(华盛顿大学二年级在读博士生)

近年来,数字病理学的蓬勃发展成为了精准医学加速突破的重要组成部分。在癌症护理过程中,利用全切片成像技术将肿瘤组织样本转换为高分辨率的数字图像,已经成为常规技术。高达十亿像素级别的病理学图片包含多样的肿瘤微环境信息,为癌症分型诊断,生存率分析以及精准免疫治疗提供了前所未有的契机。

近期,生成式人工智能革命为准确感知、分析病理学图片中的海量信息提供了强有力的解决方案。与此同时,多模态生成式人工智能技术的突破更将助力从时空多尺度理解数字病理学图片并与其他生物医学模态相融合,从而更好刻画患者疾病演变、发展过程,协助医生进行临床诊断和治疗。

然而,由于数字病例学图片的大规模、高像素、特征复杂等特点,从计算角度高效处理和理解其中的复杂模式十分具有挑战性。每张全切片数字化转型之后将包含数十亿像素,其面积达到自然图像的十几万倍,应用现有的计算机视觉模型难度较大。传统的视觉模型,如 Vision Transformer,其计算复杂度随着输入图片的大小的增加快速上升。同时,临床医学数据具有跨尺度、多模态和高噪声等特点,而现有的病理学模型大多基于标准公开数据集,依然同现实世界的应用具有不小的距离。

为此,来自微软研究院、美国 Providence 的医疗网络和华盛顿大学的研究人员,共同提出了首个全切片尺度的数字病理学模型 GigaPath。

据介绍,GigaPath模型采取两阶段的级联结构,以及微软研究院近期开发的 LongNet 架构,高效解决了十亿像素级别图像的处理和理解问题。研究人员对 GigaPath 在真实世界的数据上进行了大规模预训练,从 Providence 旗下 28 家美国医院的 3 万病人收集到 17 万张全切片数字病理学图片,共计 13 亿张病理学图块。

实验结果表明,GigaPath 在 26 个任务——包含 9 个癌症分型和 17 项病理组学任务——中的 25 项任务取得领先效果,在 18 项任务中显著高于现有方法。

研究人员表示,该研究展示了全切片尺度层面的建模和大规模真实世界数据的预训练极其重要,同时,GigaPath 也将为更加先进的癌症护理和临床发现提供全新可能。值得一提的是,GigaPath 的模型和代码已经开源。

方法

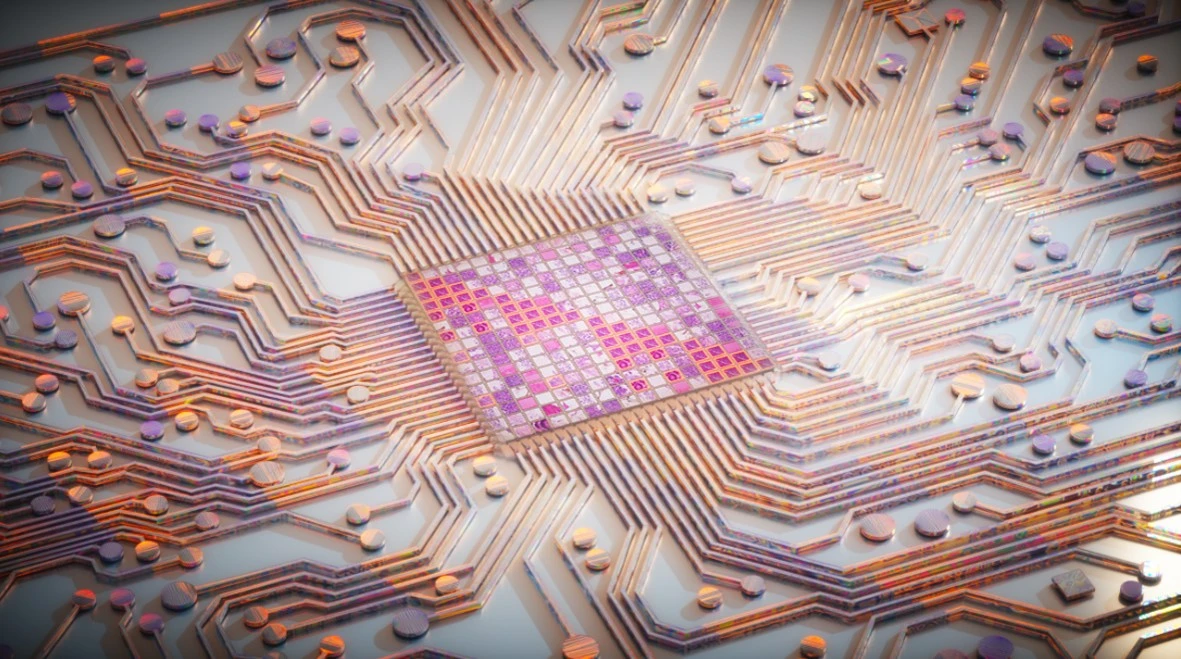

GigaPath 采用两阶段课程学习,包括使用 DINOv2 的图块级预训练和使用带有 LongNet 的掩码自动编码器的全切片级预训练,如下图。

图|GigaPath 模型示意图

DINOv2 是一种标准的自监督方法,在训练教师和学生 Vision Transformer 时结合了对比损失和掩码重建损失。然而,由于自注意力自身带来的计算挑战,其应用仅限于小图像,例如 256 × 256 图块。对于全切片级建模,研究团队将扩张注意力(Dilated Attention)从 LongNet 应用于数字病理学,如下图。

图|LongNet 模型示意图

为了处理整张全切片的长图像图块序列,他们引入了一系列递增的尺寸,用于将图块序列细分为给定尺寸的片段。对于较大的片段,LongNet 引入稀疏注意力,稀疏性与片段长度成正比,从而抵消平方增长。最大的尺寸片段将覆盖整个全切片。这能够以系统的方式捕获远程依赖关系,同时保持计算的易处理性(上下文长度呈线性)。

主要实验结果

在癌症分型诊断方面,任务目标定位于根据病理切片对细粒度亚型进行分类。例如,对于卵巢癌,模型需要区分六种亚型:透明细胞卵巢癌、子宫内膜样卵巢癌、高级别浆液性卵巢癌、低级别浆液性卵巢癌、粘液性卵巢癌和卵巢癌肉瘤。**GigaPath 在所有九项癌症分型任务中均获得领先效果,在其中六项癌症类别分型中准确率提升具有显著性。**对于六种癌症(乳腺癌、肾癌、肝癌、脑癌、卵巢癌、中枢神经系统癌),GigaPath 的 AUROC 达到 90% 或更高。这对于癌症诊断和预后等精准健康领域的下游应用来说是个好的开始。

在病理组学任务中,任务目标定位于仅根据全切片图像预测肿瘤是否表现出特定的临床相关基因突变。该预测任务有助于揭示组织形态和遗传途径之间难以被人类察觉的丰富联系。除了一些已知特定癌症类型和基因突变对之外,全切片图像中存在多少基因突变信号仍是一个尚无答案的问题。此外,在一些实验中,研究人员考虑了泛癌场景,即在所有癌症类型和非常多样化的肿瘤形态中识别基因突变的通用信号。在如此具有挑战性的场景中,GigaPath 在 18 项任务中的 17 项中再次达到了领先性能,在 18 项任务中的 12 项中显著优于第二名。Gigapath 可以在整个全切片水平上提取遗传相关的泛癌和亚型特异性形态特征,为真实世界场景下的复杂未来研究方向打开了大门。

此外,研究者通过引入病理报告进一步证明了 GigaPath 在多模态视觉语言任务上的潜力。此前,关于病理视觉语言预训练的工作往往集中在图块级别的小图像上。相反,GigaPath 探索全切片级别的视觉语言预训练。通过继续对病理学报告对进行预训练,利用报告语义来对齐病理学图像的隐空间表征。

这比传统的视觉语言预训练更具挑战性,在不利用任何单个图像图块和文本片段之间的细粒度对齐信息的情况下,GigaPath 在标准视觉语言任务中显着优于三种最先进的病理学视觉语言模型。

总结

通过丰富全面的实验,研究人员证明了 GigaPath 的相关研究工作是全切片层面预训练和多模态视觉语言建模层面的良好实践。值得一提的是,尽管 GigaPath 在多任务上取得了领先效果,在某些特定任务层面依然具有较大的进步空间。同时,尽管研究人员探索了视觉语言多模态任务,但在朝向搭建病理学层面的多模态对话助手的道路上,依然有很多具体问题需要探索。

GigaPath 是横跨微软研究院、Providence 医疗系统和华盛顿大学保罗艾伦计算机学院的合作项目。其中,来自微软研究院和华盛顿大学的二年级博士生许涵文和来自微软研究院的首席研究员 Naoto Usuyama 为论文共同第一作者。来自微软研究院 Health Futures 团队的 General Manager Dr.Hoifung Poon(潘海峰),华盛顿大学的王晟教授,以及 Providence 的 Dr.Carlo Bifulco 为论文的共同通讯作者。

许涵文:华盛顿大学二年级在读博士生。研究方向为 AI 和医学交叉。科研成果发表于Nature、Nature Communications、Nature Machine Intelligence 和 AAAI 等。曾担任 Nature Communications、Nature Computational Science 等子刊审稿人。

王晟:华盛顿大学计算机系助理教授,研究方向专注于AI和医学交叉。科研成果发表于Nature、Science、Nature Biotechnology、Nature Machine Intelligence 和 The Lancet Oncology,研究转化成果被 Mayo Clinic、Chan Zuckerberg Biohub、UW Medicine、Providence 等多个医疗机构使用。

潘海峰:微软研究院 Health Futures General Manager,研究方向为生成式 AI 基础研究以及精准医疗应用。在多个 AI 顶会获最佳论文奖,在 HuggingFace 上发布的开源生物医学大模型总下载量达数千万次,部分研究成果开始在合作的医疗机构和制药公司中转化为应用。

扫码下载APP

扫码下载APP

科普中国APP

科普中国APP

科普中国

科普中国

科普中国

科普中国