以往,谈及对合成语音的刻板印象,很多人会联想到《星球大战》中的C-3PO——那个有着近似人类外形金光闪闪的家伙,它是整个系列影片中毫无争议的搞笑担当,其动作僵硬而滑稽,说起话来喋喋不休,声音中混杂着轻微的交流声和金属质感的回声。直到今天,它那独特的嗓音,仍然是很多科幻片中人工智能发声的模板。

第一部《星球大战》公映于1977年,彼时,个人电脑才刚刚走出实验室,人们对于人工智能的想象力仍受限于时代。去年,该系列推出了最后一部作品《星球大战:天行者崛起》,C-3PO的声音还是人们熟悉的老样子。而现实中,智能语音技术飞速发展,取而代之的是听感越来越趋于自然、逼真的“合成人声”,让越来越多的企业于实现了与客户的多模态互动。

合成人声的用途相当广泛,我们熟知的便是手机中的语音助手,用户可通过简单的人机对话,获知天气、路况等实时信息,也可命令手机完成拨号、查询等任务。这一类应用被称作实时语音合成,它对基于云的计算力提出了很高的要求,除了需要对声音的自然度不断地进行优化外,实时合成对于语音合成引擎和平台架构也都有着极高的要求,必须保障在极低的延迟下,提供准确、稳定、自然的声音内容。另一类常见的应用是利用人工智能语音合成有声内容,这类应用通常会在语音服务端进行非实时的批量合成,然后再将有声内容文件提供给用户。有声内容合成的主要挑战在于如何通过多种角色扮演和丰富情感表达,降低听众单向接收有声内容的听觉疲劳。

以往,有声书需要由专业朗诵者来录制,制作周期长达数月且成本高昂。如今,通过智能合成语音录制有声书,制作周期可缩短至几小时,甚至是几分钟。即便在需要人工干预校对和声音编辑的情况下,制作周期也可缩短至数周,节省了大量的人力、物力及时间成本,且得到的效果几乎与真人朗诵别无二致。今年的“世界读书日”,由周迅与公益组织红丹丹联合发起的为视障人士读书活动,向我们展示了语音合成技术的新高度。在此之前,创建一个高质量的语音合成模型需要以大量真人原声为样本进行机器学习,样本量通常会超过10小时或10000句。而这次公益活动的主办方采用了由微软最新开发的深度神经网络语音合成定制系统,只采集了半小时大约500句的周迅原声录音,便通过深度定制的语音模型,惟妙惟肖地复原了周迅的声音。

这里所说的“复原”不只是周迅颇具特色的声线,也包括周迅在朗读时的语气、情绪、语调、抑扬顿挫等。可以想象,随着这一技术的普及,有声书行业也将随之发生巨大的改变。微软将在国际残疾人日捐赠的100小时有声书籍正昭示着这种改变的开始。

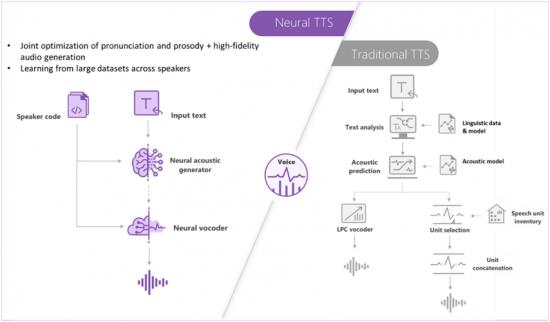

微软深度神经网络是基于Azure云的端到端语音合成系统,由前端、声学模型和声码器三部分组成。前端主要解决基于语义理解的文本发音问题,比如“2020”在表示年份和数字时的读法不一样,这是上下文关联问题;再比如“堡”字,用于地名时应读作“铺”,“解”用在姓氏上应读作“谢”,这都是多音字问题;还有“一会儿”这类词,不能读成三个字,后两个字应合并为儿化音,这是语言习惯问题。声学模型负责为语音赋予韵律,比如语速、语调、停顿、重音和情绪变化等。最后一部分声码器负责还原语音的声学特征,也就是一般所说的嗓音或声线,如振幅、频率、波长等。

深度神经网络模型是当前最先进的语音合成技术,但相应的主流产品在合成效率、效果,以及所需声音样本量上,却存在很大差异。以样本量为例,微软的语音合成定制技术处于行业领先地位,一般情况下,只需要不超过2000句的内容,就可以做到非常逼真的还原。那么,在周迅的案例中,是如何做到只需500句甚至更少的声音素材就达到类似效果呢?微软还有一个“杀器”——通用模型。通用模型是在对海量语料库进行大数据分析的基础上,不断训练深度神经网络去学习人类语言与发声特征后得到的。目前微软通用语料库的容量已经超过3000小时,覆盖了50多个语种,通过它提炼出来的通用模型已经熟练掌握了这50多种语言的几乎全部发声规律,甚至包括真人说话时换气和咽口水的细节都可以模仿出来。当微软需要基于像周迅这样只有500句话甚至更少内容的语料库做语音定制时,便可以在通用模型基础上,通过迁移学习法来建立周迅声音的扩展模型。

目前,微软的语音合成定制系统只需要半小时左右的声音样本便可建立定制语音模型,与传统TTS建模所需的至少10小时或10000句的声音样本量相比,是一个从量到质的飞跃。这一飞跃使得面向更多的企业甚至于普通消费者的个人声音定制成为可能。

微软之所以能在语音合成领域保持领先地位,主要得益于其20多年来在算法和定制模型上所积累的深厚功力。自从1991年微软研究院成立以来,微软一直将语音作为主要的研究领域,储备、积累了大量的人工智能相关技术。2018年9月,微软率先开始测试基于深度神经网络的端到端语音合成系统,为人工智能语音技术的发展揭开了新的一页。

前不久,微软将其定制的通用中文发声与市场上的主流产品进行了盲测对比,微软的MOS得分(5分制)为4.35,居于领先地位,表明合成语音与真人声音已经非常接近(真人的MOS得分为4.41)。

除了语音助手和有声书籍录制外,语音合成技术还广泛应用于智能语音客服领域,这也是微软目前在to B领域的主要发力点,比如很多航空公司、电商平台、电信运营商等都在尝试使用微软的智能语音客服来缓解人工压力。智能语音客服可以解决很多常见的标准化问题,减少客户的等待时间,为客户带来更好的服务体验。在应对突发事件方面,智能语音客服更有得天独厚的优势,很多突发事件都会造成客户咨询量在短时间内爆发式增长,在这种情况下,企业如果增设人工客服,一方面可能在时间上来不及,另一方面仓促上岗也可能导致服务质量的难以保证。

目前,微软为企业定制智能语音客服大致需要300至2000句语料训练,以满足特定应用场景的需求;对于需要定制适用于多场景、富有多种情绪甚至涵盖多语种的品牌声音的企业而言,语料训练则有更高要求。

上述两种定制目前都会有人工参与测试和适当调校并向客户提供灵活的接入方式,即通过API或SDK接入微软的Azure公有云,实现端到端的实时合成。如果客户有特殊需求,产品也可部署在私有云甚至离线设备中。未来,这两种系统都将实现自动化定制。实际上,微软已经邀请合作伙伴开始小范围的自动化系统测试,可能在不久的将来正式发布此系列产品。

可以预期,伴随着相关技术的发展,智能语音在个人及商业领域中的应用场景将更加丰富,不断细分的合成语音服务也会给我们带来更多的体验和惊喜。同时,微软提出了人工智能六项伦理道德准则:公平、可靠和安全、隐私和保证、包容、透明和责任。倡导负责任的人工智能。这些原则将为人工智能的发展保驾护航,予力全球每一人、每一组织,成就不凡!

直播链接:https://live.bilibili.com/h5/4306336

*本文图片均来源于网络

智能相对论(微信ID:aixdlun):

•AI产业新媒体;

•今日头条青云计划获奖者TOP10;

•澎湃新闻科技榜单月度top5;

•文章长期“霸占”钛媒体热门文章排行榜TOP10;

•著有《人工智能 十万个为什么》

•【重点关注领域】智能家电(含白电、黑电、智能手机、无人机等AIoT设备)、智能驾驶、AI+医疗、机器人、物联网、AI+金融、AI+教育、AR/VR、云计算、开发者以及背后的芯片、算法等。

扫码下载APP

扫码下载APP

科普中国APP

科普中国APP

科普中国

科普中国

科普中国

科普中国