计算光学可以理解为信息编码的光学成像方法,"其本质是光场信息的获取和解译,是在几何光学成像的基础上引入物理光学信息,以信息传递为准则,通过信息获取更高维度的信息"。计算光学成像是下一代光电成像技术,是光电成像技术步入信息时代的必然产物。

背景篇——光电成像的原理

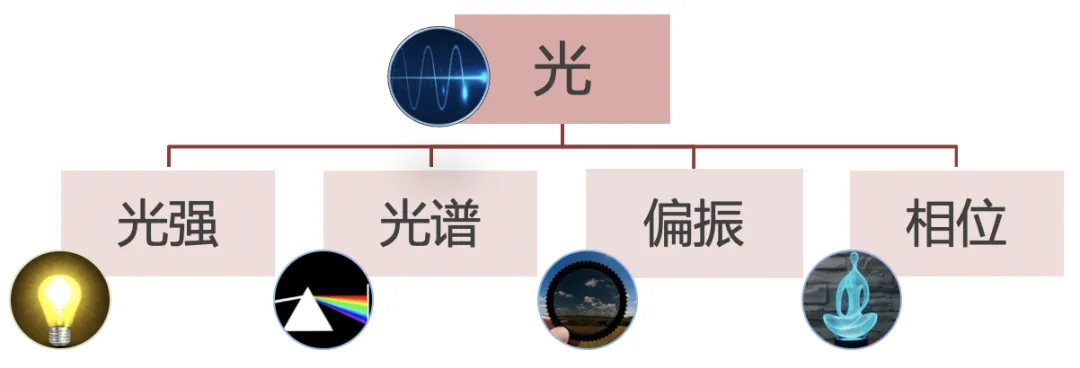

光电成像的本质是光场信息的获取与解译。所谓的光场解译是指对传统光电成像系统中所捕捉到的图像信息进行更深入的分析和解读。传统光电成像系统只能记录二维空间上的光强度分布,类似于人眼视觉。然而,实际上,成像系统中所包含的信息要比我们所看到的图像更多。光场解译则是通过对这些信息的分析和解读,来获取更多有用的信息。通过光场解译,我们可以对一些隐含在图像中的信息进行提取和解读,因而引出了计算光学成像。

图1 光场包含的信息

什么是计算光学成像

计算光学成像在传统几何光学的基础上,有机融入了物理光学的信息,如偏振、相位、轨道角动量等物理量,以信息传递为准则,多维度获取光场信息,并结合数学和信号处理知识,深度挖掘光场信息,通过物理过程解译获取更高维度的信息,是下一代的光电成像技术。

和传统成像的比较

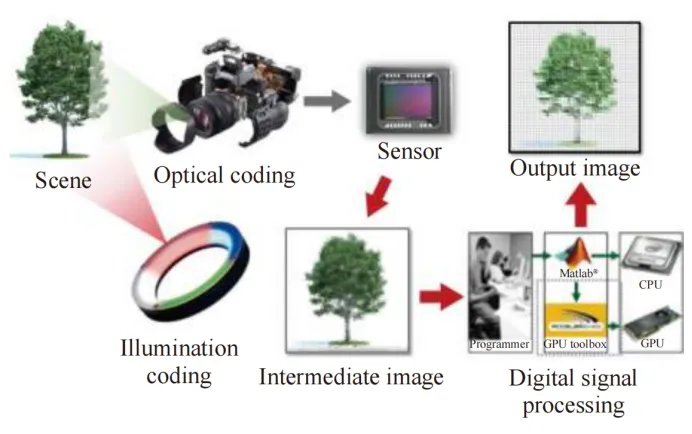

传统光学成像系统采用的是“先成像,后处理”的成像方式,即当成像效果不佳时,需要使用Photoshop、“美图秀秀”等工具对图像进一步的加工。这时图像处理算法被认为是后处理过程,并不纳入成像系统设计的考虑之中。

计算光学成像采用的“先调制,再拍摄,最后解调”的成像方式。将光学系统 (照明、光学器件、光探测器)与数字图像处理算法作为一个整体考虑,前端成像元件与后端数据处理二者相辅相成,成为有机的整体。

图2 计算光学成像系统的成像过程

计算光学成像通过对照明与成像系统引入可控的编码,如照明编码、波前编码、孔径编码等,将更多的光场信息调制到传感器拍摄到的原始图像中,这个图像又被称作中间像(Intermediate image),因为这个图像调制了很多额外的光场信息,因此往往无法直接使用和观测。然后在解调阶段,将上述调制拍摄阶段建立的基于几何光学、波动光学的数学模型进行“逆向求解”,用计算重构的方式来获取更多的光场信息。也就是说“计算成像”中的图像不是直接拍摄到的,而是通过“编解码”的方式计算得到的,光学编码有孔径编码、探测器编码等多种方式,这也就是计算成像中计算的含义。

发展简述

“计算成像”思想最早应用在光电探测系统的合成孔径雷达中,美国科罗拉多大学在1984年提出真正意义上采用“计算成像”思想联合设计光学,1995年Dowski和 Cathey提出了波前编码技术,是计算光学成像技术从理论走向实际应用的转折点。2004 年,Levoy课题组构建了多相机阵列系统,将计算光学成像应用于合成孔径成像、高速摄影、HDR成像。2006年Lytro 公司,先后推出了Lytro I、Lytro II两款商业级手持式微透镜型光场相机,可实现先拍照后对焦的全景深拍摄,光场成像从此进入了大众的视野。

国内计算光学成像研究也在和国际同步进行。中国科学院光电研究院计算光学成像技术实验室在计算光谱、光场和主动三维成像等方面进行了大量研究;清华大学国家信息实验室、光电工程研究所在计算光场成像、显微成像等方面做出重要贡献;西安电子科技大学计算成像重点实验室开展了基于散射成像、偏振成像、广域高分辨率计算成像等技术的研究;北京理工大学光学成像与计算实验室、测量与成像实验室也针对计算显示、计算光谱成像等提出了优化的解决方案;南京理工大学智能计算成像实验室在定量相位成像、数字全息成像和计算三维成像等方面取得优秀成果。

技术篇

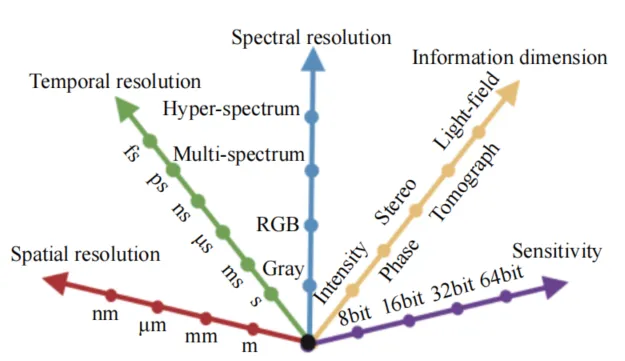

计算光学成像技术的出现延伸并扩展了人眼的视觉特性,创新地将传统光电成像流程中末端的信息处理和计算拓展到成像过程中,将一些传统部分物理上难以突破的光学问题转换为数学和信息处理问题,将硬件设计与软件计算相结合。充分挖掘光信号的信息处理的潜力,解决传统光电成像技术中“看不见”、“看不清”、“看不全”的问题,朝着更高的分辨率,更远的作用距离,更广的视场,更小的光学成像体系,更强的环境适应性发展。

图3 光学成像技术的五方面发展目标

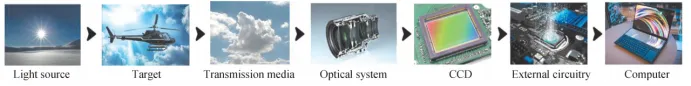

与链路单一计算、独立优化的传统光电成像不同,计算成像通过引入全链路一体化全局优化思想,将传输介质(如大气、水体等)也并入成像模型中,可带来作用距离提升、环境适应性提升等,突破传统成像的极限。其全链路包括光源(Light source)、成像目标(Target)、传输介质(Transmission media)、光学系统(optical system)、感光电子元器件(CCD)、外部电路(External circuitry)、计算机(Computer)等。

图4 全链路光路成像模型

本文着重从光场采集及三维显示两个方面对光场技术进行介绍。

光场采集现有的光场采集方法可分为三个类型:时序采集、多传感器采集和多路复用采集。采集光场的多视点信息可以用于光场的显示。

时序采集

时序采集一般将传统单体相机安装到机械移动装置上,通过调节机械装置来对目标场景进行不同视角图像采集。然而这种方式,在移动机械装置时需要耗费一定时间,所以仅能拍摄静态物体,为了解决这个问题,多传感器采集法应运而生。

多传感器采集

多传感器采集一般指基于相机阵列(Camera Array)的光场相机。多相机组合法采用多个传统相机组成相机阵列,形成有多个镜头投影中心组成虚拟投影参考平面,以及多个CCD(或CMOS)组成的虚拟成像平面。通过多个相机同时来获取目标场景中同一个点处不同视角的光线辐射强度,每个相机拍摄的图像可以看作是光场在不同角度的采样图像。

调整相机阵列里各个子相机间的距离,可以实现整个相机阵列的不同用途。当所有相机间的距离比较小时,整个相机阵列可以看做一个单目相机;当所有的相机之间的距离为中等尺度时,整个相机阵列可以看作是一个拥有合成孔径的相机;当所有的相机之间距离很大时,整个相机阵列可以看成一个多目相机,此时可以得到物体的多视角信息,从而利用多视角信息构建全景照片。

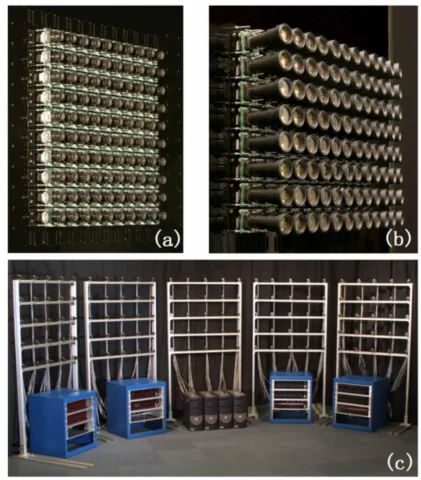

比较有代表性有Jason Yang于2002年在MIT搭建出的全世界第一套8x8个相机组成的实时相机阵列,可同时获取目标场景64个视角的图像。Bennett Wilburn在2005年进一步增加相机数量到约100个能力更强,但是成本高体积大,Pelican公司2013年通过优化光学设计和应用光场超分辨算法制造了小巧的4x4相机阵列,并且是独立的光场相机模块,整个设备比硬币还小,可集成到手机中。

图5 Bennett Wilburn于2005年设计的大规模光场相机阵列

多路复用成像

多传感器采集光场缺点是只能用于特定区域采集静止或缓慢移动的场景。而多路复用成像方法可以解决这个问题。多路复用成像分为空间复用和频率复用。

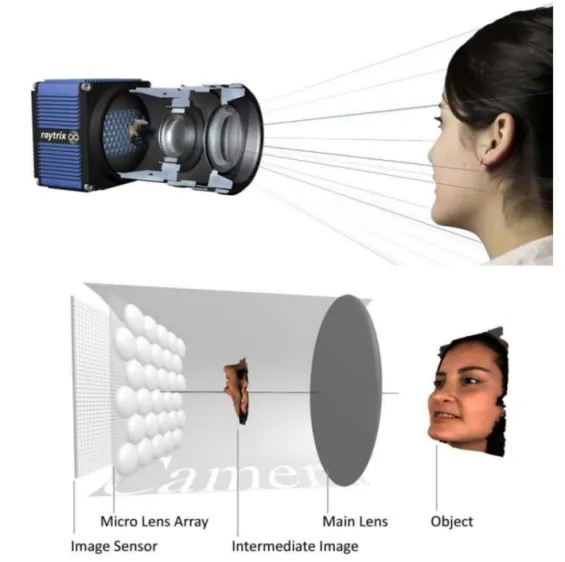

空间复用:采用在图像传感器上安装微透镜阵列来实现。例如全光相机,也称为光场相机,其形状、体积、操作和普通相机相似,通过将角域(角度信息)复用到空间(或频率)域中来将四维光场编码到二维传感器平面。

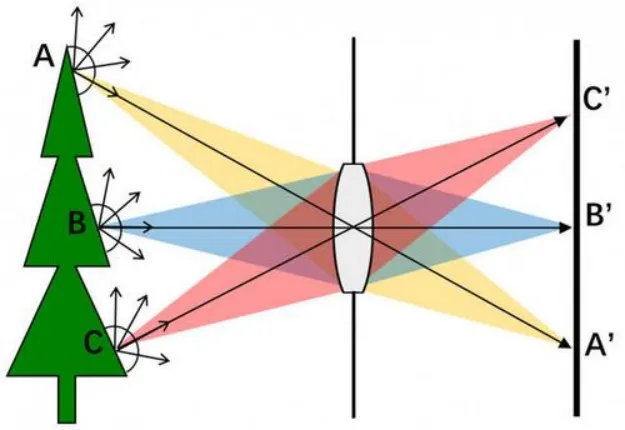

下面讲一下光场相机的原理。现实生活中的物体表面一般为漫反射,譬如下图中A点,如果为理想漫反射表面,会向半球180度范围内发出光线,采用透镜小孔成像,物体表面A点在一定角度范围内发出的所有光线经过透镜聚焦在成像传感器A’点,并对该角度范围内所有光线进行积分,积分结果作为A点像素值。这大大增加了成像的信噪比,但同时也将A点在该角度范围内各方向的光线耦合在一起。

图6 透镜小孔成像原理

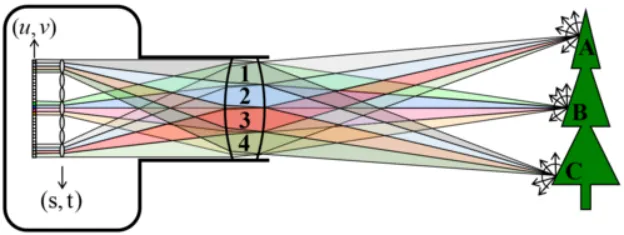

全光函数是指在空间和时间上描述光场变化的函数,为获取全光函数中的角度信息,1992年Adelson提出了全光相机(也叫光场相机)模型,在传统相机基础上加入了微透镜阵列,物体表面光线首先经过主镜头,然后经过微透镜,最后到达成像传感器,每个微透镜捕获光线在主透镜处的所有角度分布。如图7所示,物体表面A点在FOP(Field Of Parallax,视差范围)角度范围内发出的光线(同一点的不同角度光线用不同颜色表示)进入相机主镜头并聚焦于微透镜,微透镜将光线分成4x4束,并被成像传感器上对应的16个像素记录。类似的,空间中其它发光点,例如B点和C点,在其FOP角度范围内的光线都被分成4x4束并被分别记录。

图 7 透镜阵列4D光场的图像分辨率和角度分辨率

2011年Lytro公司根据全光相机原理发售了世界上第一款消费级光场相机Lytro。

图 8 Raytrix 基于微透镜阵列的光场相机

空间复用是采集光场最广泛使用的方法,但也存在问题,就是图像分辨率和角度分辨率两者相互制约,此消彼长。另外由于微透镜直接距离很小,所以采集光场的视差角度较小,只能在较小的角度范围内变换视点。

频率复用:近年来随着压缩感知等信息论技术的发展,为了解决空间复用方法必须对图像分辨率和角度分辨率进行折中的问题,也产生了一些例如基于掩膜(Mask)的频率复用方法。 基于掩膜的方案可以通过事先对光场的学习得到光场字典,从而去掉光场的冗余性实现了采集更少的数据量便可重建出完整的光场。如图9所示,在传统相机的成像光路中加入一片半透明的编码掩膜,掩膜上每个像素点的光线透过率都不一样,进入光圈的光线在到达成像传感器之前会被掩膜调制,经过掩膜调制后的光线到达成像传感器。通过事先学习的完备光场字典,从单幅采集编码的2D调制图像就可以重建出完整的光场。

图 9 掩膜光场相机原理

基于编码掩膜的光场采集方案虽然可以解决图像分辨率和角度分辨率的矛盾,但是,透光率不能达到100%,因此会造成光线信号强度损失,导致成像信噪比低;同时所重建的最终光场图像是通过从被调制的图像中进行解调制得到,而不是直接通过成像传感器采集得到,因此会依赖已学习光场字典的正确性。

综上所述,现有的光场采集方式主要是通过多传感器采集的相机阵列方式或空间多路复用成像的基于微透镜的全光相机或频域多路复用的基于掩膜的全光相机对光线进行多角度采样来记录光场。不同的光场采集设备通过不同的技术方案各自解决了一定的问题,按照不同的场景需求,不断的对软硬件方面进行突破,随着技术的不断进步,相信在光场采集方面会有更好更轻量的解决方案。

三维显示

真实世界的景物是三维立体的,传统的二维显示只能获取空间物体某一截面的二维图像信息,缺乏深度信息,存在信息量缺失和真实性不足的问题。因此,具有更好沉浸感的三维显示技术是新型显示技术的重要发展方向。

三维深度线索

三维深度线索泛指一切可以为使用者提供深度感知的特征信息,是三维显示效果的关键,分为心理学和生理学两类。

心理学深度线索是指二维画面诱发三维感知的特征信息,主要包括线性透视、遮挡、阴影、纹理和先验知识等。生理学深度线索指的是通过三维场景空间位置关系诱发的三维感知特征信息,可进一步分为双目深度线索和单目深度线索两类。

对于三维显示而言,心理学深度线索更容易实现,传统的超高清通过细致纹理和阴影等效果也可以实现一定的立体感,例如户外大屏裸眼3D效果和手机裸眼3D彩铃等。生理学线索实现难度相对较大,随着技术发展,双目立体视觉已经相对成熟,通过VR设备、裸眼3D设备等渐入大众视野,而单目深度线索相对更难实现。

三维显示技术分类

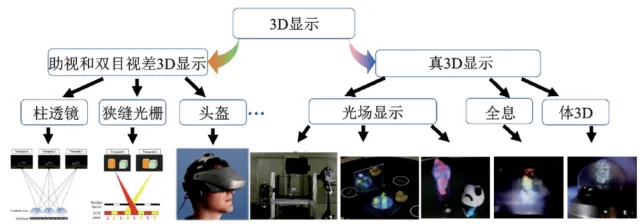

根据实现立体效果的机制不同,三维显示可分为:观看者佩戴眼镜等助视设备的助视3D显示,如红蓝眼镜等;此外还有向左右眼投射不同的图像来产生立体感的双目视差3D显示;以及真3D显示,提供近乎真实的3D图像信息和真正的物理景深,包含光场显示、体显示、全息显示等。助视3D技术效果差比较陈旧,在此不细述,下面择要介绍双目视差 3D 显示、光场显示、体显示和全息显示。

图 10 3D显示分类

双目视差3D

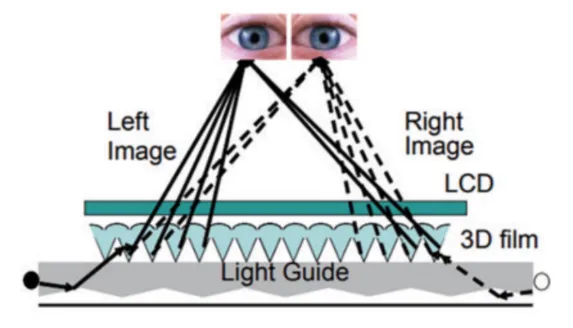

双目视差3D有传统基于狭缝光栅、柱状透镜方法,也有基于指向背光的视差型三维显示,维持了观看者在观看区域内左眼或右眼所感知的面板分辨率。其利用时空复用3D显示技术,基于控制光线出射方向的指向型背光结构设计,结合高速刷新的LCD 显示技术,利用时间复用的方法实现全分辨率的3D显示效果。

图 11 指向背光显示原理

光场显示

视差型三维显示在某一时刻视显示呈现的是几个分立的视点图像,而光场显示呈现的是在一定角度范围内连续或准连续的视点图像。光场显示技术按实现原理可划分为压缩光场显示、指向光场显示和集成成像显示等。

压缩光场显示

也称为层叠光场显示,因其采用多层结构,利用层叠的显示层实现对一定角度范围内的光线强度的调制。因具有多层屏幕结构,其可以实现高动态范围或者超分辨率的2D图像显示。压缩光场显示利用了三维场景视点图像之间的强相关性,将一定观看角度的目标光场“压缩”到多张二维图案中。但是也因如此,其在显示不相关的多视点图像时会有很大的串扰。压缩光场显示视场角有限,通过增加显示器的层数或提高刷新率可以扩大视角,但是增加显示器层数将增加硬件和计算复杂度,光学效率也会以指数形式降低。

指向光场显示

可以一定程度解决以上问题。2012年,G. Wetzstein 等人通过在多层 LCD 后部添加一块指向型背光板,提出了一项新的“张量”显示技术。这种结构通过多层 LCD 屏幕和多帧率的光场分解,达到了扩大视场角的目的,视场角由原先的 10°×10°提高为 50°×20°。

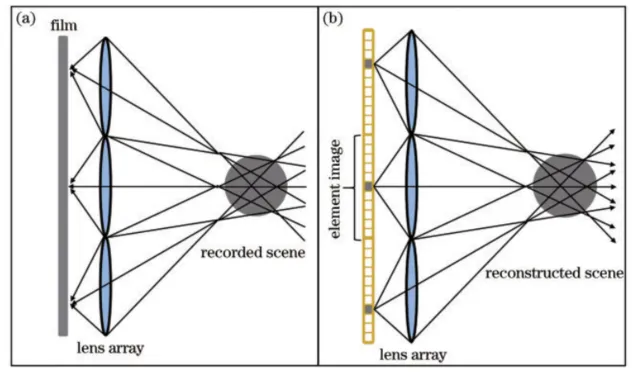

还有集成成像显示,基于柱透镜阵列的 3D 显示技术只能提供水平视差,而基于球面微透镜阵列的集成显示可提供全视差图像。其原理如图12所示, 图像记录时,使用微透镜阵列或者针孔阵列将不同视角的图像“集成”地记录在一张胶片上。图像再现时,多视角图像元的出射光线在微透镜阵列前方再现出来,将显示面板上的元素图像成像到不同的视点位置,形成完整的 3D 图像。集成成像显示的优点是结构紧凑简单,能够再现全视差3D图像,并可提供运动视差信息。但是其分辨率下降严重、视场角比较受限。

图 12 集成摄影与集成成像

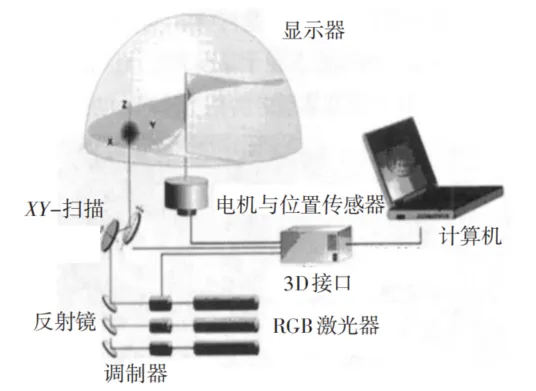

体显示

光场显示可以提供所有种类的心理学线索和双目深度线索,并可以提供运动视差和遮挡变化等单目深度线索。但是,传统的光场显示难以完整提供聚焦线索。而体三维显示通过点亮空间中的发光物质或者“体素”可在一定体积的空间内完成显示过程,通过人眼暂留效应可以提供聚焦线索,但是需要复杂的机械扫描装置,可移动性差。

图 13 旋转扫描式立体显示原理

全息显示

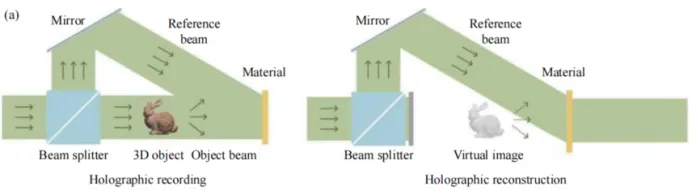

理论上,全息显示可以提供所有种类的深度线索,被认为是三维显示的终极实现方式。全息术,又称全息照相术,指在照相胶片或干板上通过记录光波的振幅和位相分布并再现物体三维图像的技术,按其物理意义可分为波前记录和波前重建两部分。在波前记录过程中,物光波与参考光波在全息图平面发生干涉,干涉条纹的强度被记录下来。由于已知参考光波的振幅和相位,全息术就是把物光波的复振幅信号转换为强度信号,从而记录了物光波的全部信息。在波前重建过程中,用一束重建光波对全息图进行照射,重建光波经过全息图的衍射光波在特定的位置上可以重建出物光波的振幅与相位信息。

图 14 全息记录与全息重建

综上所述,随着三维显示技术的发展,三维显示的效果得到了显著的提升。传统的基于心理线索和生理线索中双目视差的裸眼3D,由于其原理简单,成本低的有点得到了广泛应用,但是由于仅提供有限的视角,目前在体验上还有较大的上升空间。为了提供更多的生理学、心理学深度线索,光场显示技术、体显示技术、全息显示技术都得到了飞速的发展,但是这些技术往往实现成本较高,大多还处于研究阶段,距离真正的消费级应用还有一定距离。

应用篇

计算光学成像技术在各个领域的应用非常广泛,前期主要在医学、天文、军事、工业检测等领域。近几年随着虚拟/增强现实、裸眼3D等业务的发展,计算光学成像技术逐渐应用到生活,走进大众视野。通过光学成像技术,可以帮助人们更好地理解和掌握周围环境的信息,提高工作效率,提升生活质量,推动科学技术的发展。在当今社会中,光学成像技术的应用已经成为各个领域中不可或缺的关键技术之一。

虚拟/增强现实

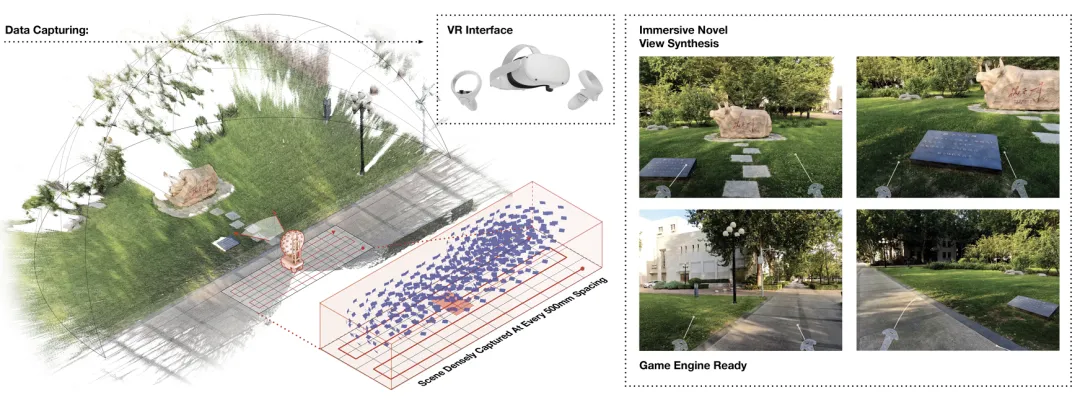

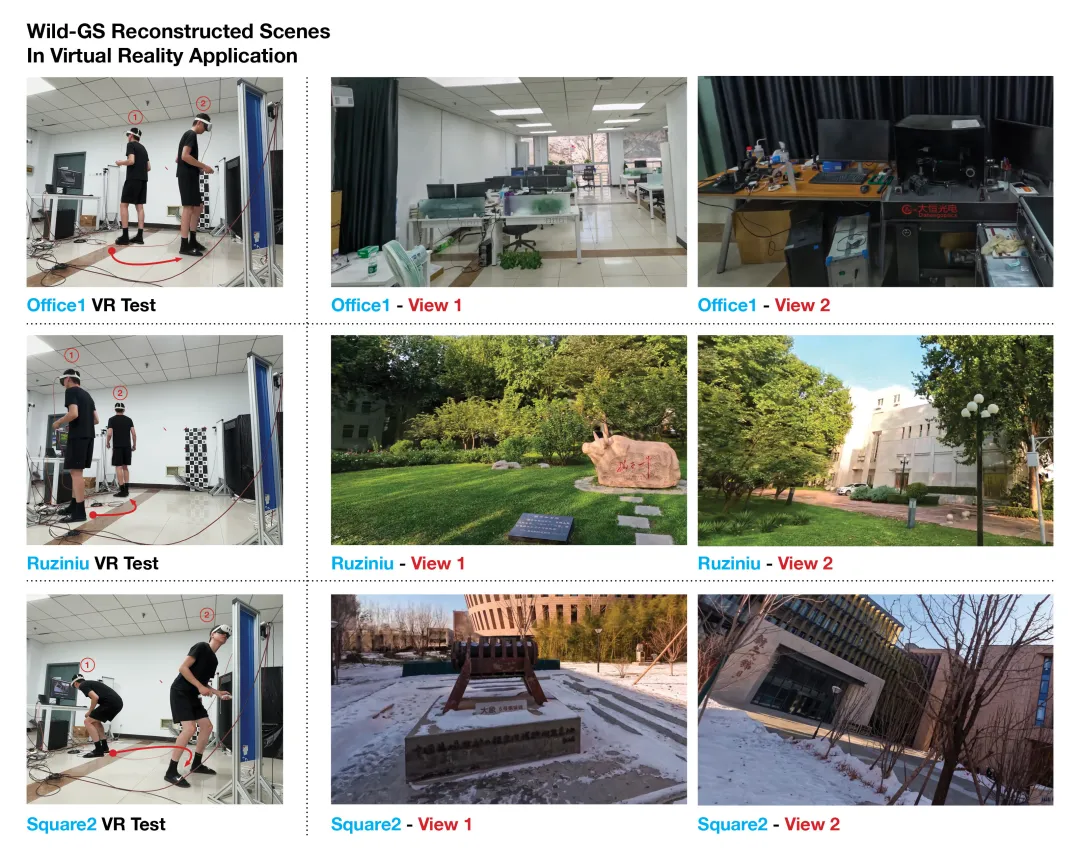

通过传统的结构光技术可以快速进行物体三维模型制作,而结合深度学习技术,通过多角度图像/视频,可以快速生成三维模型。 例如清华大学的研究团队开发了一种新型的多摄像头大空间密集光场捕获系统——Den-SOFT,是目前公共领域内质量和视点密度领先的数据集,有望激发以空间为中心的光场重建研究,为沉浸式虚拟/增强现实体验提供更高质量的三维场景。

图 15 清华Den-SOFT

可以仅借助消费级RGB-D摄像头,实现多人实时三维人体重建,人体模型可用于实时AR展示,在线教育和游戏等。 可参考清华大学论文《Function4D: Real-time Human Volumetric Capture fromVery Sparse Consumer RGBD Sensors》等。

图16 清华大学RGB-D实时三维重建

在专业级动作捕捉驱动方面,光学动捕通过对目标特定光点的监视和跟踪来完成运动捕捉。可使用高分辨率光学红外相机进行捕捉。譬如凌云光的FZMotion AI多模态运动捕捉系统可实现高精度高速AI人体动作识别的多模态运动捕捉。

图 17 FZMotion AI多模态运动捕捉系统

在消费级驱动方面,结合深度学习,可使用少量的消费级RGB-D摄像机便可实现实时多人运动捕捉。

裸眼3D

消费级的裸眼3D发展迅速,2023.3 中兴在巴展发布 LCD Nubia Pad 3D(与美国Leia公司合作),采用的为可切换指向光源模组方式,显示分辨率2K,支持2D/3D显示实时切换,售价约1300欧。在内容上,nubia和中国移动咪咕公司深度合作,共同为用户带来了多维交互沉浸式的全新游戏、视频、直播、音乐体验,为数智娱乐行业带来了更为广阔的发展空间。

图 18 中兴nubia Pad 3D

而在光场显示领域,looking glass等可以实现多视点光场显示。

图 19 清华大学光场显示研究

影视制作

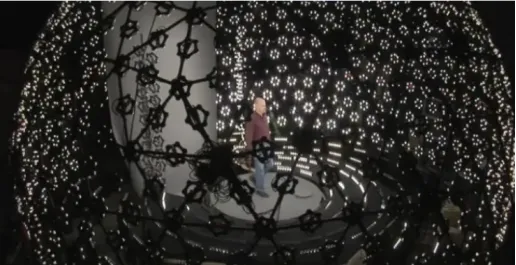

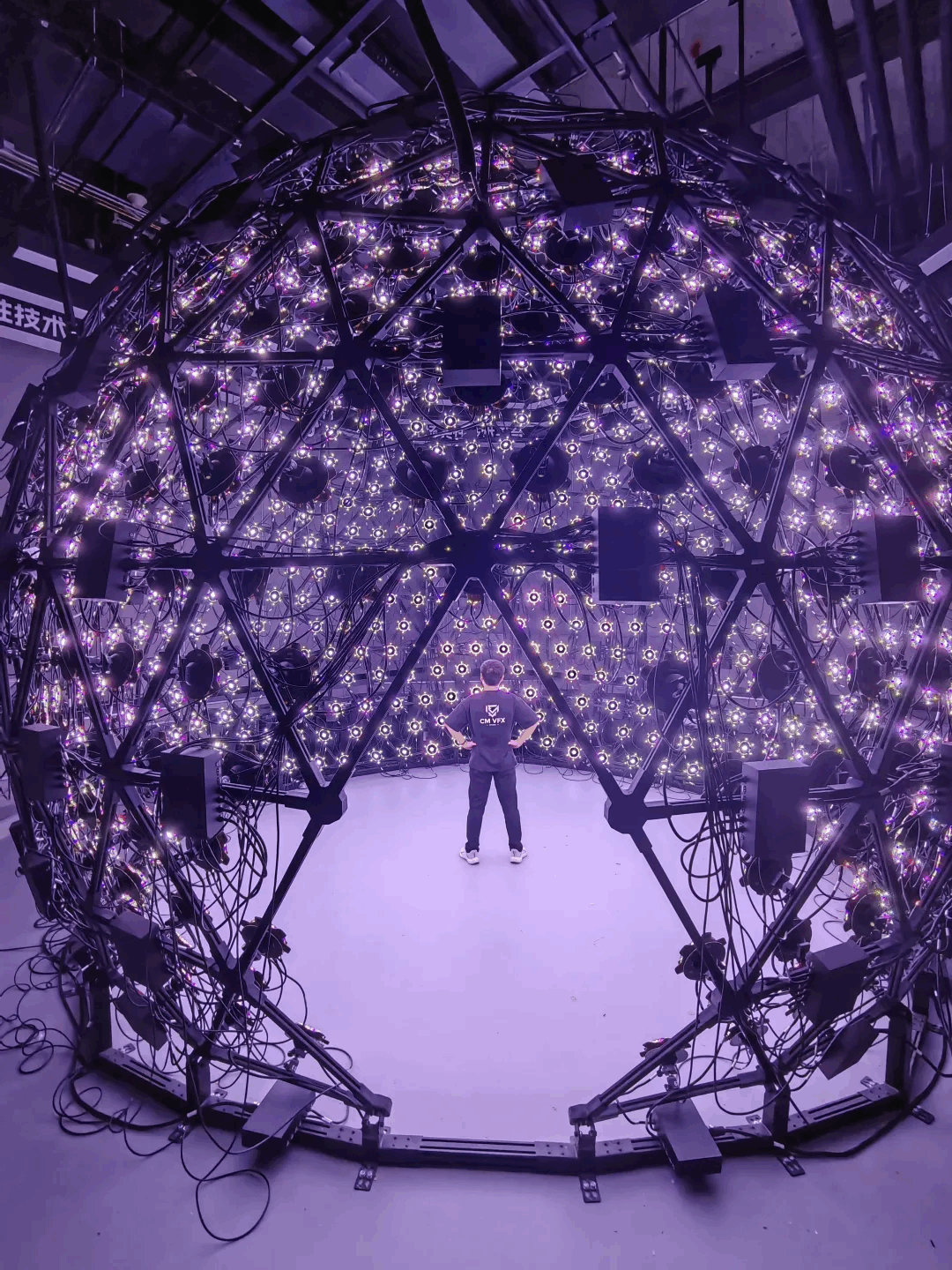

Light Stage光场采集系统被广泛用于好莱坞电影制作。Light Stage是由美国南加州大学ICT Graphic Lab的保罗•德贝维奇(Paul Debevec)所领导开发的一个高保真的三维采集重建平台系统。该系统以高逼真度的3D人脸重建为主,并已经应用于好莱坞电影渲染中。从第一代系统Light Stage 1于2000年诞生,至今已经升级到Light Stage 6,最新的一代系统命名为Light Stage X。

图 20 Light Stage 6 采集系统样机

在国内凌云光、影眸科技等企业也建设有自研的类似Light Stage的采集系统。譬如凌云光的LuStage数字人光场建模系统,可以实现0.1mm毛孔级重建。 该系统包括自主设计研发并独立完成生产制造的756台6色LED(RGBWCA)、直径6.6m的375面体支架、嵌入式控制平台、100台4K相机组成。每个光源包含97颗LED灯珠,每颗灯珠的亮度、发光时间、频率可控。整个系统可以模拟出输入图像或视频中的环境光照,也可以逐一时刻点亮某个方向的光源,还可以实现XYZ三个轴像的梯度光照,利用球面上的相机同步光源采集图像,从面实现影视照明、AI训练数据采集等用途。

图 21 LuStage数字人光场建模系统

医疗

在医疗领域,中国工程院院士、清华大学成像与智能技术实验室主任戴琼海团队实现了可以在手机中配备高分辨率集成显微镜,无需额外的电子设备即可刺激皮肤健康的新的便携式诊断。其他皮肤病,如痤疮、天疱疮和牛皮癣,也可以通过集成显微镜和相应的智能算法一次性轻松诊断。

图 22 手机中配备的集成显微镜

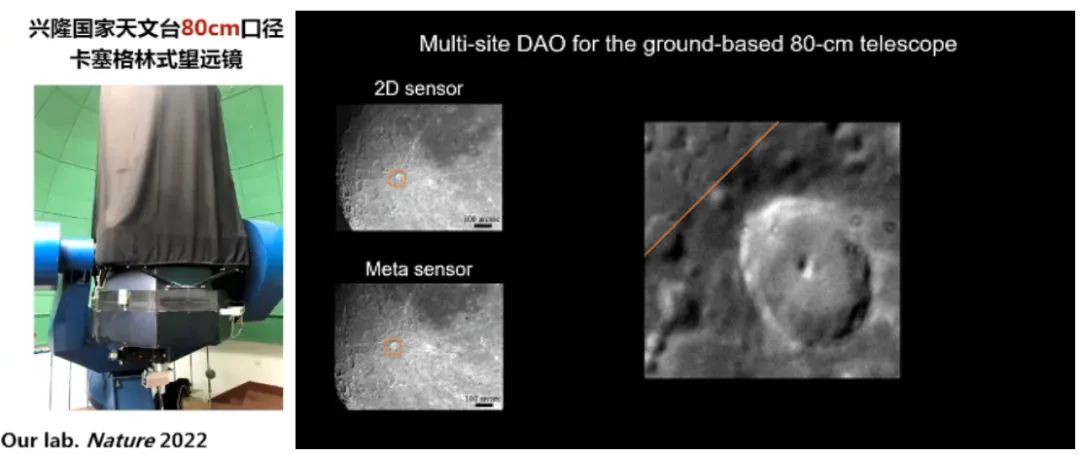

天文

在天文领域,清华大学戴琼海院士团队研发的数字自适应光学地月观测系统,在国家天文台兴隆观测站实现40万公里地对月成像测试,可直接对接现有光学系统;降低了现有大口径光学系统体积,将成本降低三个数量级以上;实现了大视场多区域内空间非一致的环境湍流像差矫正,重建高分辨图像。

图 23 数字自适应地月观测

计算光学成像目前在各个领域都得到了相关应用,计算光学成像的市场发展迅速,随着元宇宙的发展,计算光学成像在内容生产,显示等方面越来越重要。随着技术的发展,计算光学成像所涉及的软件及硬件的市场前景也越来越广阔。

展望篇

传统光电成像技术因为受工业化设计思想限制,性能已经接近极限,计算成像技术是信息时代发展的必然。

光场采集有望拓展元宇宙新的输入方式

传统的光电成像只能获得二维数据,而人眼能够感知到比传统相机更大的数据密度、维度的信息。人眼具有精密的结构,可以实时捕捉现实场景中多维光场信息,再结合大脑的运算,人眼+大脑就是一个天然的精密的计算光学成像系统。而目前使用的传统拍摄方式会丢失大量的高维数据信息,导致采集的效率大大下降。而如果设计一套像人眼+大脑一样的计算光学系统,就可以实现对现实场景的高效实时采集,通过4D的光场数据可以解决目前二维图像中很多无法解决的难题,最终实现真正的智能机器视觉。

全息显示是未来3D显示的终极形态

通过光场技术,重现一个真实的三维世界,这是人类多年的梦想。目前的三维显示技术无法提供全部的深度线索,会带来各种头晕、图像不真实等问题。而全息显示将在现实世界中展示三维物体,使得虚拟和现实完美融合,现实和虚拟世界之间的边界不再明显。

图24 电影《阿凡达》中描绘的全息三维军事沙盘

光场+AI是计算光学成像的必由之路

深度学习已逐步深入多个光学技术领域,推动了诸多光学技术的发展。深度学习具有强大的运算、数据演化和非线性逆问题求解能力,为更复杂的光学系统设计优化求解提供了新思路、新方法。同时如何基于深度学习来简化光学系统,降低光学系统成本,提高光场采集效果也是一个重大难题。目前基于神经辐射场的三维重建技术日新月异,这背后是人们对轻量级光场三维重建的无限期望。

计算光学成像技术有望成就5G、6G杀手级应用

随着图像编解码及显示硬件技术的发展,传统的二维视频的分辨率已经从2K发展到4K、8K、16K,已经超越了普通人眼的分辨极限。再向上提高图像分辨率带来的收益已经很小。但是随着元宇宙技术的发展,内容从二维走向三维,随之而来的是信息量的指数级上升。

传统的在二维平面中已经接近人眼极限的高分辨率信息在三维显示中则显得捉襟见肘。

后5G乃至6G时代,以微纳光场调控及超表面光学技术为代表的手机裸眼3D显示应用,有可能带动移动通信网络实 现跨越式发展,成为5G乃至6G网络的“杀手级”应用。毫米波、太赫兹和泛光通信(属于6G光子学的范畴)等技术能够让通信峰值带宽、连续频谱带宽、网络时延和流量密度等网络承载能力指标得到飞跃性的提升。

后5G乃至6G生命期有可能是数据“大爆炸”的时代。例如为了给用户呈现逼真的显示效果,每秒3D 高清视频可能需要Gbit级以上的端到端流量,而不需要眼镜辅助的全息3D立体图像需要3~30亿像素,所产生的庞大的Tbit级数据对移动网络带来前所未有的压力。首先对3D对象数据压缩成为第一个面临的挑战,庞大的数据必然要求高的压缩比。其次海量3D对象数据存储也是一个难题,3D对象携带的信息量十分巨大,在存储和读写方面可能也会突破现在的极限。最后对3D数据的传输与计算也是关键的问题,如此庞大的数据如何保证实时的传输与计算,边缘算力的升级改造似乎也是必然。

此外计算光学成像从生产到体验相关标准仍然是空白,随着技术进步和产业落地也需要补足。随着计算成像技术的不断发展和理论的不断完善,计算成像体系也将更加丰富、立体、有效,使计算成像能够真正实现更高(成像分辨率)、更远(探测距离)、更大 (成像视场)、更小(功耗和体积)的目标。

【参考资料】[1] SHAO Xiaopeng,SU Yun,LIU Jinpeng,et al. Connotation and System of Computational Imaging(Invited)[J]. Acta Photonica Sinica,2021,50(5):0511001

[2]CHENLiang,YUShao-hua. Research on the Impact of Holographic 3D Display on the Capacity of the Post-5G/6G Network

[3] Qiao Wen,Zhou Fengbin,Chen Linsen.Towards application of mobile devices: the status and future of glasses-free 3D display

[4] WANG Cheng, ZHU Xiang-bing.Research Development of Stereoscopic Display Technology

[5] Gao Chen, Li Ziyin, Wu Rengmao, Li Haifeng, Liu Xu.Development and Prospect of Portable Three-Dimensional Displays

[6] Cao Liangcai,He Zehao,Liu Kexuan,Sui Xiaomeng.Progress and challenges in dynamic holographic 3D display for the metaverse (Invited)

[7] KANG Jiaxin, WANG Wenwen, PENG Yuyan, ZHANG Jiazhen, ZHOU Xiongtu,YAN Qun, GUO Tailiang, ZHANG Yongai.Research Status and Trends of Light Field Display Technology

[8] 方璐, 戴琼海. 计算光场成像[J]. 光学学报, 2020, 40(1): 1-11.

[9] Zuo Chao,Chen Qian.Computational optical imaging: An overview

[10] 高金铭,郭劲英,戴安丽,司徒国海.光学系统设计:从迭代优化到人工智能

[11] 邵晓鹏.计算光学成像[OL].西电科大广电成像工程中心(公众号)

作者:柳建龙 毕蕾

单位:中国移动通信集团咪咕公司

扫码下载APP

扫码下载APP

科普中国APP

科普中国APP

科普中国

科普中国

科普中国

科普中国