相信不少朋友已经体验过文生图这类模型,比如 MidJourney、Stable Diffusion 或 OpenAI 的 DALL·E 等。只需简单输入一段文字,就能获得高质量的图像,这也让许多平面设计师倍感压力。接下来,我们将深入探讨这类模型的工作原理。乍一听似乎很复杂,但其实基本概念相当直观。

主流的文生图模型大多采用了一种名为“扩散”(Diffusion)的技术。扩散的概念源自物理学领域,可以这样理解:想象一杯清水,当一滴墨水滴入水中时,墨水会逐渐与水混合,最终使得整杯水变色。这个过程中,墨水分子与水分子均匀混合,正是扩散现象的体现。文生图模型的核心思想正是基于这样的扩散过程。

以一张小猫的图片为例。首先,我们可以通过向图片中添加随机像素(即噪点),使其变得模糊不清。随着噪点数量的增加,图片将逐渐失去原有的细节,最终呈现出类似电视信号不佳时出现的雪花状画面。这种完全随机的像素分布被称为“白噪声”。

以一张小猫的图片为例。首先,我们可以通过向图片中添加随机像素(即噪点),使其变得模糊不清。随着噪点数量的增加,图片将逐渐失去原有的细节,最终呈现出类似电视信号不佳时出现的雪花状画面。这种完全随机的像素分布被称为“白噪声”。

假设上述过程是可逆的,即我们可以从白噪声开始,逐步去除噪点,使原本模糊的画面逐渐恢复清晰。在这个过程中,隐藏在白噪声中的图像逐渐浮现,就像是小猫的轮廓逐渐显现一样。因此,文生图模型的扩散过程实际上是一种逆向操作——即“去噪”。

假设上述过程是可逆的,即我们可以从白噪声开始,逐步去除噪点,使原本模糊的画面逐渐恢复清晰。在这个过程中,隐藏在白噪声中的图像逐渐浮现,就像是小猫的轮廓逐渐显现一样。因此,文生图模型的扩散过程实际上是一种逆向操作——即“去噪”。

不过,这里还有一个问题:我们如何将文本信息融入这一过程中?答案将在后续的解释中揭晓。

让我们回到刚才讨论的去噪过程。假设我们现在要训练一个大模型,我们可以暂且称其为“图像生成器”。该模型的功能是从含噪图像中移除噪声,从而生成清晰的图像。具体来说,模型中的蓝色部分负责实现从含噪图像到清晰图像的转换。

但这只是开始。为了使模型能够根据文本描述生成相应的图像,我们需要赋予它文本理解的能力。因此,我们需要另一个模型来实现这一点。这个模型将通过大量的带注释图像进行训练——每张图像都配有一段描述性的文本。

但这只是开始。为了使模型能够根据文本描述生成相应的图像,我们需要赋予它文本理解的能力。因此,我们需要另一个模型来实现这一点。这个模型将通过大量的带注释图像进行训练——每张图像都配有一段描述性的文本。

例如,一张“小狗在草地上奔跑”的图片会配上相应的文字描述。通过训练,模型将学会理解文本与图像之间的关联。

例如,一张“小狗在草地上奔跑”的图片会配上相应的文字描述。通过训练,模型将学会理解文本与图像之间的关联。

简单来说,当模型接收到“一只躺着的猫”这样的文本输入时,它会在其内部生成与之匹配的图像,而不会生成不相关的图像,比如“在草地上奔跑的小狗”。

最终形成的“文本转图像”(Text-to-Image)模型包含了多个子模型。具体来说,模型首先需要具备文本理解能力,然后接收一个初始的含噪图像作为“画布”。接下来,模型中的“去噪”部分(即图像生成器)根据文本内容移除噪声。最后,生成的图像数据通过图像解码器转换成可视化的图像。

最终形成的“文本转图像”(Text-to-Image)模型包含了多个子模型。具体来说,模型首先需要具备文本理解能力,然后接收一个初始的含噪图像作为“画布”。接下来,模型中的“去噪”部分(即图像生成器)根据文本内容移除噪声。最后,生成的图像数据通过图像解码器转换成可视化的图像。

通过这种方式,模型可以根据提供的文本描述生成相应的图像,无论是山水画还是小猫。这个过程类似于在一张充满随机噪声的画布上,根据给定的文字描述逐步去除噪声,最终呈现出清晰的图像。

同样的原理也可以应用于视频生成。视频本质上是由一系列连续的静态图像组成,快速播放时给人以动态的感觉。因此,生成视频的过程类似于连续生成多个静态图像,并将它们组合在一起形成连续的画面。在这个过程中,同样会用到diffusion技术。

几个月前SORA大模型出现后有人认为,SORA已经能够理解物理世界,通用人工智能(AGI)将在一两年内实现。这种观点往往出自一些知名人士或意见领袖。然而,面对这样的说法,我们不能盲目跟风,而是要用批判性思维来进行深入分析。

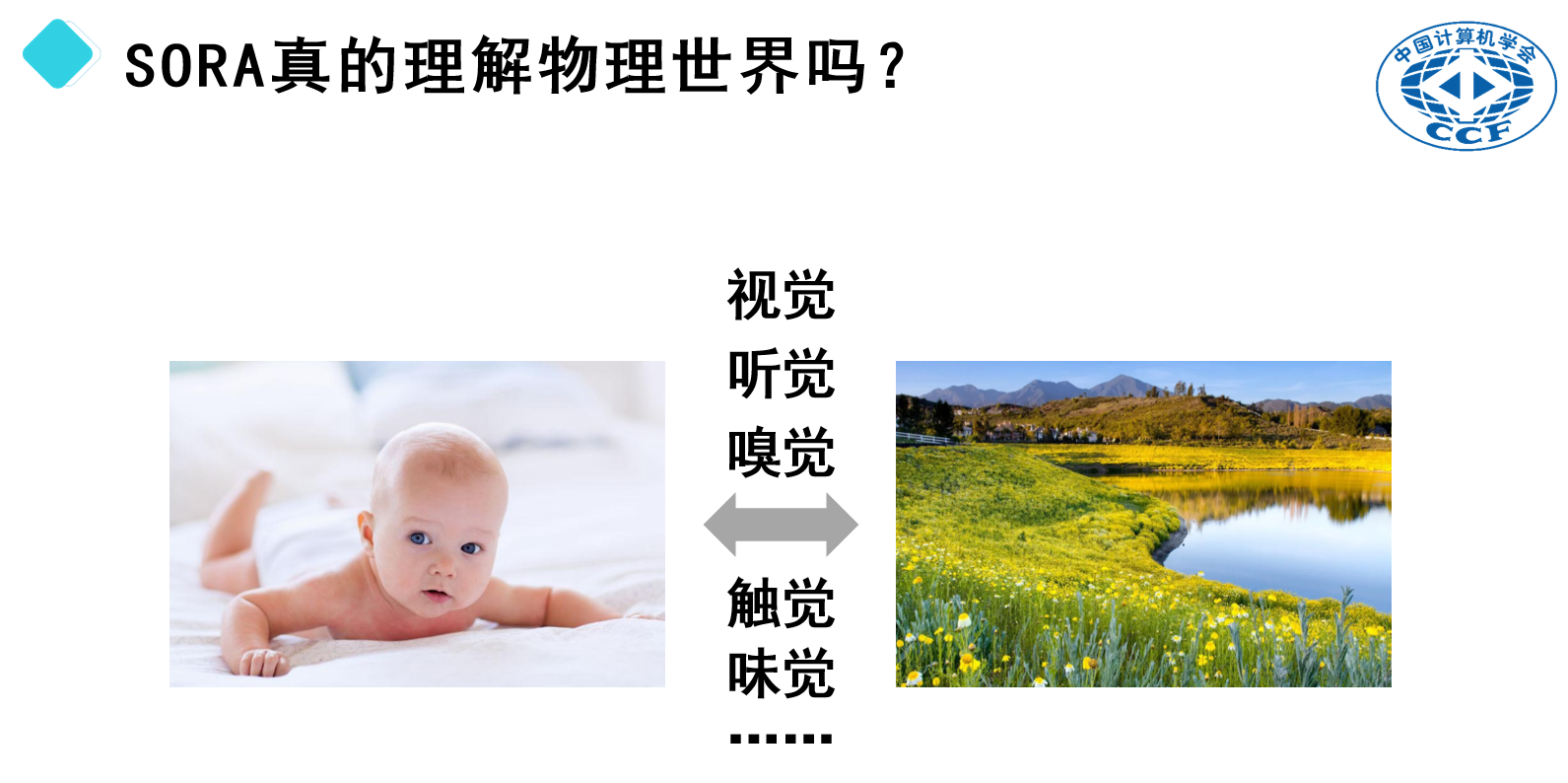

我们先来看看婴儿是如何在短短几个月内学会理解物理世界的。婴儿出生时就像一张白纸,但到八九个月大时,他们已经掌握了基本的物理规则。例如,当婴儿看到物体违背了重力法则而悬浮时,他们会表现出明显的惊讶,这意味着他们已经理解了物体不应无故悬浮的基本原则。

我们先来看看婴儿是如何在短短几个月内学会理解物理世界的。婴儿出生时就像一张白纸,但到八九个月大时,他们已经掌握了基本的物理规则。例如,当婴儿看到物体违背了重力法则而悬浮时,他们会表现出明显的惊讶,这意味着他们已经理解了物体不应无故悬浮的基本原则。

人类之所以能够在短时间内迅速学习这些知识,很大程度上归功于我们拥有的多种感官——视觉、听觉、嗅觉、触觉和味觉。通过这些感官,我们可以全方位地感知周围环境。举个例子,当一个婴儿触摸到装有热水的杯子时,他不仅能看到杯子,还能感受到水的温度,并在烫手时立即缩回手。杯子落地摔碎时,他不仅能听到声音,还能看到碎片四散的场景。所有这些感官体验共同作用,促进了大脑的发展,并帮助我们理解物理世界。

相比之下,当前的SORA大模型,主要依靠大量的视频数据进行训练。这些模型仅具备视觉输入,缺乏嗅觉、触觉和味觉等其他感官信息。如果我们将这些模型与婴儿进行类比,那么可以想象,如果一个婴儿被限制在一个透明箱子里,只能通过视觉来观察世界,而无法使用其他感官,那么他将难以发展出全面的理解能力。因此,在目前的技术条件下,期望这些模型能够像人类那样理解物理世界显然是不切实际的。

获取更多内容,请关注“孙老师聊人工智能”公众号。

扫码下载APP

扫码下载APP

科普中国APP

科普中国APP

科普中国

科普中国

科普中国

科普中国