互信息(Mutual Information)是信息论里一种有用的信息度量,它可以看成是一个随机变量中包含的关于另一个随机变量的信息量,或者说是一个随机变量由于已知另一个随机变量而减少的不肯定性1。

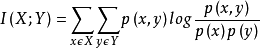

定义设两个随机变量 的联合分布为

的联合分布为 ,边际分布分别为

,边际分布分别为 ,互信息

,互信息 是联合分布

是联合分布 与乘积分布

与乘积分布 的相对熵,2即

的相对熵,2即

含义互信息与多元对数似然比检验以及皮尔森 校验有着密切的联系3。

校验有着密切的联系3。

信息的含义信息是物质、能量、信息及其属性的标示。逆维纳信息定义

信息是确定性的增加。逆香农信息定义

信息是事物现象及其属性标识的集合。

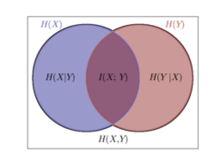

互信息的含义信息论中的互信息

一般而言,信道中总是存在着噪声和干扰,信源发出消息x,通过信道后信宿只可能收到由于干扰作用引起的某种变形的y。信宿收到y后推测信源发出x的概率,这一过程可由后验概率p(x|y)来描述。相应地,信源发出x的概率p(x)称为先验概率。我们定义x的后验概率与先验概率比值的对数为y对x的互信息量(简称互信息)4。

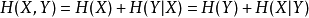

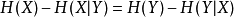

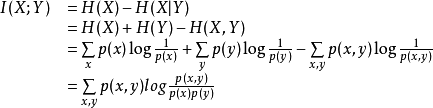

根据熵的连锁规则,有

因此,

这个差叫做X和Y的互信息,记作I(X;Y)。

按照熵的定义展开可以得到:

性质互信息的性质(1) 对称性——I(xi ;yj) = I(yj ;xi)

(2) X与Y独立时——I(xi ;yj) = 0

(3) I(xi;yj) 可为正、负、0

I(xi;yj) 可为正、负、0的举例

设yj代表“闪电”,则

当xi代表“打雷”时,I(xi/yj) = 0,I(xi;yj) = I(xi) >0

当xi代表“下雨”时,I(xi/yj) > 0

当xi代表“雾天”时,I(xi/yj) = I(xi),I(xi;yj) = 0

当xi代表“飞机正点起飞”时,I(xi/yj)>I(xi),I(xi;yj)

扫码下载APP

扫码下载APP

科普中国APP

科普中国APP

科普中国

科普中国

科普中国

科普中国