AIGC大模型可解释性理论基础-贝叶斯重整化?

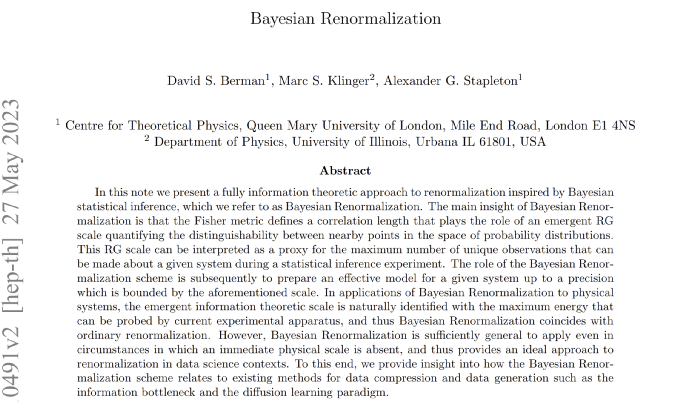

摘 要

在这篇文章中,我们提出了一种受贝叶斯统计推断启发的完全信息理论的重整化方法,我们称之为贝叶斯重整化。贝叶斯重整化的主要观点是,Fisher度量定义了一个相关长度,它起到了一个突现的RG(重整化群)尺度的作用,量化了概率分布空间中邻近点之间的可区分性。这个RG尺度可以被解释为在统计推断实验中可以对给定系统进行的唯一观测的最大数量的代理。贝叶斯重整化方案的作用是随后为给定系统准备一个有效的模型,其精度由上述尺度限定。在贝叶斯重整化对物理系统的应用中,突现的信息理论尺度自然与当前实验设备可以探测到的最大能量相一致,因此贝叶斯重整化与普通重整化是一致的。然而,贝叶斯重整化具有足够的通用性,即使在没有直接物理尺度的情况下也能应用,从而为数据科学环境中的重整化提供了一种理想的方法。为此,我们提供了关于贝叶斯重整化方案如何与现有的数据压缩和数据生成方法(如信息瓶颈和扩散学习范式)相关的见解。

介绍

在[1]中提出了一个问题:当我们获得更多的数据时,我们对系统的理解是如何提高的? 自然语言表述这个问题是通过统计推断。从统计推理的角度来看,我们对系统的理解是编码在我们针对系统如何工作的貌似合理解释的概率中。这些解释被形式化为根据各种参数界定的可观察数据的概率模型。分配给这些模型中的每个模型的概率随后被编码到一个称为贝叶斯后验分布的对象中,该对象可以被认为是可观测数据所有可能概率分布的概率分布。就这些概念而言,我们通过推导出一个显式方程,将后验分布的演变作为收集数据量的函数,成功地表述了上述问题的答案。我们将这个方程以及更广泛地使用贝叶斯推理动态更新一个人的信念的想法,称为动态贝叶斯推理(Dynamic Bayesian Inference,或Dynamical Bayes,DB)。DB的一个核心观察是,随着新数据的收集,“当前”最可能的模型流经“可能模型”的空间,流向真正负责生成观测数据的概率分布。

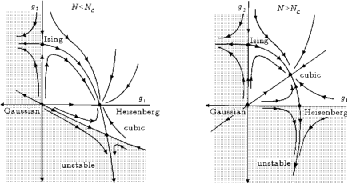

“学习”在模型空间中引发流动的想法立即唤起了一种不同类型的“元”理论:重整化群(RG)。RG是一组广泛关注形式化尺度在我们对物理理论的理解和表述中的作用的思想和策略。在最初的形式中,正如Kadanoff 和Wilson[2-4]所设想的那样,重整化群包括一个由大量自由度描述的系统,并执行粗粒度操作,其中自由度子集被组合在一起平均,以形成新的集体变量。在物理应用中,粗粒化邻域是基于与局部性相关的考虑来确定的——也就是说,在物理空间中邻近的自由度被连接在一起。出于这个原因,重整化群将描述系统任意小尺度行为的理论,转变成为一个新理论,该理论仅描述受典型粗粒度邻域大小约束的距离尺度上的行为。出于我们的目的,我们将对一种相对现代的重整化形式感兴趣,它通常被称为精确重整化群(ERG:Exact Renormalization Group)[5-14]。ERG试图以一种更严格的数学方式形式化重整化的思想,将ERG流表述为由(泛函)微分方程控制的单参数理论族。

将物理理论视为构成系统的任何可观察自由度的概率分布,因此RG 粗粒度方案的效果是在可能的理论空间中诱导流动-就像在DB中一样。然而,与通过模型空间流向数据生成模型的学习情况相反,RG流从数据生成模型(UV完整理论,注:在物理学术语中,我们说,重整化群流将UV理论(即在任意小尺度上或等效的任意高能量上,有效的理论)转化为IR理论(即仅在相对大的距离上或等效的相对低的能量上,有效的理论))开始,流向一些不太完整的模型,该模型仅对原始自由度的一个子集保持准确。这一观察激发了这样一种想法,即重整化群流可以被视为与动态贝叶斯过程“逆”过程,前者将数据生成模型降低到近似模型,后者将近似模型带回数据生成模型。这个想法在[15]中被形式化了,我们在其中阐明,如果我们将流的方向反转,那么控制动态贝叶斯的方程在形式上相当于精确重整化群(ERG)流。更明确地说,通过丢弃数据而不是观察数据来反向执行动态贝叶斯定义了一个 ERG方案,我们将其称为动态贝叶斯重整化群方案(DB-RG)或简单的贝叶斯重整化。

在这篇文章中,我们的目标是充实贝叶斯重整化。特别是,我们想强调DB-RG方案是如何将重整化从对物理局部性的依赖中解放出来的。正如我们在上面提到的,当对物理系统进行重整化,可以实现由物理局部性直接驱动的粗粒度方案,例如,可以通过汇集包含在公共空间邻域中的自由度来定义集体变量,或者可以积分在特定高能截止点以上的动量壳层上支持的自由度。在任何一种情况下,物理尺度层次结构的存在,及其在定义RG方案中的作用确保了我们可以将ERG流解释为从UV理论开始并在某个IR 固定点结束。但是,如果我们感兴趣的重整化物理系统具有非局域相互作用,我们该怎么办呢?或者更糟糕的是,如果我们感兴趣的是对一个根本没有物理解释的模型进行重整化,该怎么办?这种情况在最近的工作中出现,这些工作试图将重整化的机制引入数据科学环境中,作为执行数据压缩和提高高维模型的可解释性和性能的工具[16-25]。

贝叶斯重整化克服了明显缺乏“真实”尺度的问题,它配备了自己的突现尺度——模型的可区分性。换句话说,模型的空间具有Fisher度量所赋予的自然信息几何结构[26-28],Fisher度量是一对概率分布之间相对熵的无限小度量。正如我们将演示的那样,DB-RG方案以一种尊重模型空间局部性的方式自动实现粗粒化,这是由Fisher度量规定的。这一事实是在推崇DB-RG用于重新规范化数据科学模型的实用性时偶然发现的新事物。在数据压缩任务和模型构建考虑中,Fisher度量被用来区分所谓的“粗糙sloppy”和“坚实stiff”参数。前者与模型输出的协变很弱,因此对应于Fisher度量的小特征值,而后者与模型输出的协变非常强,因此对应于Fisher度量的大特征值。因此,为了磨练模型的可解释性和泛化性,人们可能会对这样一种方案感兴趣,这种方案系统地抛弃了粗糙的参数,转而支持只依赖于严格参数的模型。从费雪几何的角度来看,这可以明确地认为是一种“UV正则化方案”;一种一致的方法来处理这样一个事实,即我们无法在模型空间中分辨出任意小的距离,这是识别模型所必需的,这些模型在沿着由粗糙参数协调的方向不同[29,30]。因此,解释DB-RG方案的一种方法是将其视为一种自动数据压缩算法,该算法以与物理RG积分大动量壳层相同的方式依次积分“高能”参数(例如与Fisher 度量的小特征值相关的参数)。

把前面的讨论变成更物理的语言,坚实和粗糙的参数是数据科学对相关和不相关算子概念的回答。在感兴趣的模型确实拥有“真实”尺度的情况下,这种类比就变得明确了。例如,在物理学文献[31]中观察到,在共形场论的空间中,Fisher度量与Zamolodchikov度量重合,因此后者的频谱所规定的相关和不相关算子的层次与前者所规定的坚实和粗糙参数的层次重合。以类似的脉络,但以相反的方向研究[32]发现,信息瓶颈形式化认为的对数据压缩最重要的参数[33]与传统 RG 意义上最相关的算子相吻合,前提是被压缩的模型是由局部统计场论给出的。

鉴于这些观察结果和DB-RG中突现尺度的信息理论特征,本文的另一个中心目标是鼓励读者将重整化视为一个明显的信息理论过程。例如,考虑两种理论,它们的不同之处在于存在于某些可观测动量尺度(即UV截止)之上的模态。对于所有的意图和目的,这些理论是等效的,因为没有现有的实验可以进行区分。正如我们现在所建立的,在广泛的数据科学背景下有一个明确的类比:一个人有两个模型,它们只是沿着模型流形中的“粗糙方向”不同。粗糙的参数不能被调整,除非观测的数量和/或精度由于实验限制而无法实现。因此,再一次,这样的模型应该被视为实际上是等效的。最终,这种思想表明,RG通用性类应该对应于所有模型/理论的集合,这些模型/理论产生的等效预测低于一个阈值,这个阈值是由可以收集到的有关系统的有用信息的数量设定的。从这个角度来看,尺度的相关概念始终是模型/理论空间中的可分辨性,恰好相同的信息可以在物理情况下以能量尺度进行交流,因为这种尺度限制了我们的实验能力。

本文的组织结构如下。在2.1节中,我们回顾了其原始物理背景下的精确重整化。我们强调ERG方案的一个有用子类构成泛函扩散方程的观点,正如最初被[37]推崇的那样,并认识到物理尺度在定义这种扩散性 ERG 方面所起的作用。基于重整化和扩散是等价的观点,我们在第 2.2节中将扩散视为一种有用的设备,即使没有物理尺度,也可以对数据模型进行重整化。这种基于扩散的一般数据模型重整化的图景相当于有影响力的扩散学习范式[38],其中难以处理的分布通过扩散通道运行,以便为数据生成任务生成可处理的模型。然而,在没有物理尺度的情况下,人们无法控制模型中粗粒度的信息,与物理重整化方案相反,物理重整化方案总是在真实能量尺度的层次中删除信息。这激发了第3节中介绍的贝叶斯重整化方案。在回顾了支撑贝叶斯推理的Fisher几何(第3.1节)和动态贝叶斯推理方案(第3.2节)之后,我们在第3.3节和第3.4节中明确地推导了DB-RG方案。DB-RG方案可以理解为扩散重整化的一种特定形式,其中因扩散而丢失的信息由Fisher度量控制。因此,DB-RG是我们所寻求的扩散学习的精确形式,其中由Fisher 度量引起的距离度量的逆在ERG的目的中起着能量标度的作用。最后,我们在第4节中进行了讨论,其中我们回顾了我们对重整化的新观点,并提出了DB-RG在数据科学任务中的应用以及作为一种新的理论工具的未来方向。

译者注:篇幅缘故,编译时略去了第二第三部分的详细推导,侧重介绍这种新思想以及其在数据科学中的应用潜力。

讨论

在这篇文章中,我们概述了一个关于重整化的新视角,它本质上是完全信息论的。因此,这种重整化方法适用于任意概率模型,而不仅仅是那些具有物理解释的模型。我们提出的主要见解是,Fisher度量应该被解释为在模型空间中定义一个相关长度,该模型通过概率分布的可区分性定义了一个突现尺度。从这个角度来看,贝叶斯重整化方案中的 UV截止可以理解为固定的可以对系统进行的最大可能测量数量,从而限制了在推理实验中可以访问有关数据生成模型的信息的精度。这种重整化的观点与更熟悉的物理图景是一致的,在物理图景中,可以收集到的关于一个理论的数据量是由可以在实验中探测到的能量尺度限制的。因此,再一次,UV截止决定了一组可能的独立测量。更严格地说,这种观测可以通过观察到KL散度是ERG单调来量化[37],或者即使在具有物理尺度的RG方案中,ERG核也可以用理论空间上的Fisher 度量来识别[64]。

重整化的信息理论方法允许在重整化和数据科学中的技术(如模型选择、数据压缩和数据生成)之间建立非常令人满意的联系。使用Fisher度量来定义突现的RG尺度所产生的最重要的见解之一是,“高能模式”自然地被识别为“粗糙的”参数,这些参数被系统地丢弃,以制定仅依赖于“严格”参数的“低能量”有效理论。在这方面,我们将贝叶斯重整化视为一种信息几何启发的粗粒化方案。已经通过所谓的信息瓶颈研究了重整化与数据压缩之间关系的相关视角,关于该主题的代表性论文样本见[16- 18,32] 。这里的基本思想是,信息瓶颈确定了一组低维有效自由度,这些自由度有效地编码了包含在数据实现的高维空间中的数据。从原始自由度到有效自由度的移动涉及到一个随机映射(条件概率分布),它可以被解释为一种基于粗粒度的重整化形式。除了与数据压缩的联系之外,贝叶斯重整化作为随机扩散过程的框架允许人们将其解释为[38]中引入的有影响力的扩散学习范式的细化。在未来的工作中,我们计划利用这些见解来实现贝叶斯重整化作为数据科学应用的有效工具。

虽然我们主要关注的是贝叶斯重整化在数据科学背景下的信息理论特征的价值,但我们在结束时注意到,这种重整化方法也可能在物理背景下提供新的见解。对于初学者来说,贝叶斯重整化的信息理论方法使其成为识别和量化在RG流下丢失的精确信息的理想工具。通过这种方式,人们应该能够使用贝叶斯重整化来解释和构建RG单调性定理[65-70]。另一方面,如果不包括纠缠/全息重整化(Entanglement/HolographicRenormalization),重整化的现代视角将是不完整的:[40,71-77]。将本文描述的贝叶斯重整化与上述作品中发展的重整化全息描述结合起来,是未来工作的一个挑战。与此相关的是全息背景下正则能量与费雪度量之间的关系:[78-81]。最后,物理系统中能量随熵缩放的不同方式告诉我们通常基于动量的重整化的有效性。有人可能会问一个有趣的问题,是否有一种不同的方式来执行重整化,更适合粗粒信息。特别是,对于引力理论来说,大动量壳层可能不是正确的“粗糙参数”。回想一下,引力中熵与能量的标度不同于局部量子场论。这是允许引力具有全息特性的关键因素。这里提出的观点是,能量切断实际上是信息切断。因此,这种信息理论的观点表明,人们可能会考虑一种不同于QFT的引力截止方案。这就是贝叶斯重整化原理的强大之处:它通过费雪度量自动编码相关和不相关自由度的适当指定,从而确保“从模型中积分”的自由度与粗糙参数精确对应,无论它们是什么。

致谢

我们感谢Jonathan Heckman在动态贝叶斯方面的合作,这激发了本文中的许多想法。我们也感谢SemonRezchikov和MirandaCheng在Stringdata2022期间提出的相关工作的评论,并感谢Leenoy Meshulam,AdamKline和MichaelAbbott在APS2023年3月会议上就重整化和数据科学之间的交叉点进行了有益的对话。最后,我们要感谢SamuelGoldman和RobertLeigh就精确重整化及其与纠缠重整化的关系进行的启发性讨论。DSB和AGS感谢PierreAndurand在本研究过程中的支持。MSK得到了伊利诺伊大学厄巴纳-香槟分校物理系的支持。

作者:王庆法

作者:David S.Berman, Marc S.Klinger, Alexander G.Stapleton

编译:王庆法

译者注:本文作者开创性的定义了贝叶斯重整化,并推导论证了贝叶斯重整化具有足够的通用性,即使在没有直接物理尺度的情况下也能应用,从而为数据科学环境中的重整化提供了一种理想的方法。为从理论上解释AIGC预训练与生成式大模型,建立了科学的理论基础。此文可以作为“系列文章深度解析ChatGPT获得智能的数学物理机理“中提到的第15项 “Bayesian重整化”的理论参考。

扫码下载APP

扫码下载APP

科普中国APP

科普中国APP

科普中国

科普中国

科普中国

科普中国